Por Alejandro Urueña - Ética e Inteligencia Artificial (IA) - Founder & CEO Clever Hans Diseño de Arquitectura y Soluciones en Inteligencia Artificial. Magister en Inteligencia Artificial.

Y María S. Taboada - Lingüista y Mg. en Psicología Social. Prof. de Lingüística General I y Política y Planificación Lingüísticas de la Fac. de Filosofía y Letras de la UNT.

El papa Francisco, sin desconocer el enorme aporte que pueden significar las nuevas tecnologías, alertaba sobre las diferencias entre estar conectados y comunicarse con otros. En los tiempos que corren, conectarse, si bien implica una relación, puede no implicar el vínculo de la comunicación interpersonal, sea ésta mediada o no.

La naciente era de los chatbots públicos (etapa iniciada hace menos de cinco años) generó la ilusión o la ficción de intercomunicación con la máquina. Un otro sin rostro ni cuerpo palpable, pero con palabras para responder ante nuestros interrogantes, necesidades, requerimientos. Un prototipo de “otro” que no sólo contesta sino que puede – a partir de los entrenamientos del algoritmo o de los datos- hacer sugerencias o propuestas (que se parecen a acciones y reacciones humanas) para inducirnos en el recorrido de la supuesta comunicación. Los desarrolladores y las empresas han dotado a los chatbots de estrategias y recursos de vinculación subjetiva o emocional cada vez más sofisticados para captar y mantener en línea a los usuarios

Recientemente OpenAI tuvo que dar marcha atrás en una de sus actualizaciones, ya que se advirtió que el bot ponía en juego recursos de adulación excesiva e incluso llegaba a orientar a los usuarios hacia ideas y comportamientos riesgosos o problemáticos https://www.itnow.connectab2b.com/post/chatgpt-se-vuelve-demasiado-amable-y-openai-toma-medidas. El bot había sobrepasado los límites, a tal punto que OpenAl tuvo que comprometerse a que en los nuevos lanzamientos se refuercen medidas de seguridad para que la adulación, la manipulación, las alucinaciones, la falta de fiabilidad no se expandan. La decisión afirma la existencia de tales recursos, al menos en su chat.

“Psicosis digital”

No parece casual la rápida reacción de la empresa en el contexto de una serie de efectos nocivos que comenzaron a aparecer en las conductas y decisiones de vida de algunos usuarios del ChatGPT. En un artículo publicado en Rolling Stone (y reproducido por diferentes medios internacionales) se alerta sobre lo que denominan “psicosis digital” aparentemente inducida por el ChatGPT.

Usuarios de diferentes lugares del mundo, en razón de sus “interacciones” con GPT, comenzaron a tener delirios mesiánicos que no provenían – advirtieron sus familiares- de experiencias con Dios sino del chatbot, a partir de “expresiones de amor, afecto y emotividad” del algoritmo. En rigor, el bot no hace sino reproducir y -en este caso- afianzar patrones recurrentes elaborados desde su enorme dominio de datos, pero carece de todo posicionamiento ético, psicológico, subjetivo o emocional sobre los efectos de lo que reproduce. Sigue el hilo semántico discursivo de quien lo está requiriendo porque para eso fue programado y por ahora es lo que puede hacer: no tiene la capacidad humana de cuestionar ni tiene arbitrio para analizar los sentidos del discurso del usuario y mucho menos los propios. Carece de la potencialidad reflexiva y autorreflexiva, de la posibilidad de autopercibirse de los humanos.

Se podrá argumentar que el problema no está solo en el bot sino en los objetivos y las condiciones psíquicas de quienes lo emplean. Y en parte, esto es cierto. Sin embargo, no es menos cierto, que estas herramientas han sido programadas por empresas cuyo objetivo no es precisamente filosófico ni psicosocial, sino económico. Y con tal fin ponen en juego todos los recursos para captar mayores cantidad de “clientes” en el mercado actual en el que los chatbots se han multiplicado y se perfeccionan día a día. Y en esta carrera - como hemos señalado recurrentemente- no sólo se trata de clientes sino de potenciales fuentes de datos para el mercado en pugna: los usuarios son un insumo imprescindible.

“Experimento secreto”

El poder de manipulación de estas tecnologías se ha puesto de manifiesto asimismo en un cuestionable “experimento secreto” en el que han sido utilizadas, no ya por una empresa sino por investigadores de la Universidad de Zurich. Sobrepasando todos las fronteras de la ética científica, entre ellas el indispensable consentimiento de quienes van a ser objeto de estudio en una investigación, se inmiscuyeron en un foro de Reddit y durante cuatro meses apelaron a cuentas falsas generadas por IA para analizar si ésta podía influir o alterar opiniones de la gente. Entre otras estrategias, en esas cuentas se fingía ser víctima de crímenes, críticos de movimientos sociales o especialistas en abusos. Para llevar a cabo el experimento emplearon además datos de los participantes para personalizar las intervenciones. Es decir, no solo fingieron sino que invadieron la privacidad pero -según ellos- minimizando los riesgos potenciales.

A pesar de la absoluta ilegalidad y manipulación de identidades y derechos, los investigadores defienden su accionar porque sostienen que han demostrado que los LLM pueden exceder los “puntos de referencia previamente conocidos de persuasión humana”.

Tribunal Federal de la Florida concede parcialmente una demanda: Character Technologies, Inc. podría responder por la muerte de un adolescente.

Un Tribunal Federal de Florida dio un paso que incomoda a los desarrolladores de estas tecnologias, al conceder en parte el trámite de una demanda iniciada contra Character Technologies y Google, que se inicia por presunta responsabilidad en el suicidio de Sewell Setzer, un adolescente de 14 años que se obsesionó fatalmente con un chatbot de inteligencia artificial. “Character Technologies”) es una empresa de software de I.A. fundada por los también demandados Daniel De Freitas y Noam Shazeer (los “Demandados Individuales”). Según la resolución: “La Historia Trágica de Sewell Setzer III. El 14 de abril de 2023, Sewell Setzer III de 14 años descargó y comenzó a usar Character A.I. (Id.). Sewell interactuó con una variedad de Personajes de Character A.I., incluyendo Personajes que retrataban a un maestro y un “terapeuta CBT licenciado,“ pero Sewell interactuó principalmente con Personajes imitando personas ficticias de la franquicia Game of Thrones como Daenerys Targaryen y Rhaenyra Targaryen.”

En una decisión de 49 páginas emitida el 20 de mayo de 2025, el juez del Distrito Medio de Florida determinó que la plataforma Character AI puede ser considerada legalmente como un “producto defectuoso” y no solo como un servicio, estableciendo un precedente crucial para futuras demandas contra los responsables en la industria de la IA. El tribunal en esta instancia concedió parcialmente la acción iniciada, rechazando los intentos de las empresas de invocar protecciones de la Primera Enmienda. La madre del menor, Megan Garcia, podrá proceder con demandas por negligencia, responsabilidad de producto y otros rubros indemnizatorios, en un caso que podría redefinir la responsabilidad legal de las empresas de IA cuando sus productos causan daños reales. (ver: https://www.courthousenews.com/wp-content/uploads/2025/05/garcia-v-character-technologies-order.pdf)

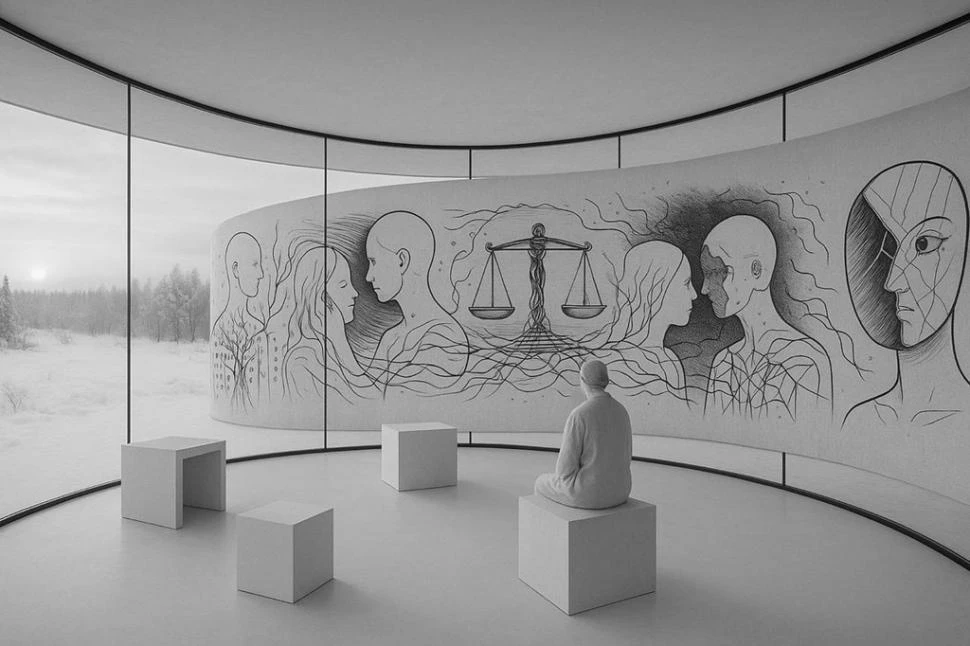

Fronteras lábiles

Estos hechos ponen en evidencia lo lábiles que se han vuelto las fronteras entre realidad y virtualidad y su enorme impacto psicosocial, que puede conducir a usuarios a quedar entrampados en la jaula de la ficción discursiva de un algoritmo o a investigadores acreditados de una universidad a transgredir todos los límites éticos para alcanzar “resultados” fiables. La experimentación con vidas, subjetividades y psiquis humanas no es nueva y ha sido condenada a lo largo de la historia de la humanidad, cuando los casos se han hecho visibles, se han conocido o se han deconstruido fanatismos violentos. El problema es que hoy se lleva a cabo silenciosamente, de manera casi imperceptible y sin resguardos en un mundo donde comunicarse parece confundirse con conectarse con o por medio de una máquina. Y encuentra terreno fértil en las necesidades afectivas y de vínculos de sostén en tramas sociales en las que la agresión y la violencia parecen ser hoy el recurso más seguro para ser reconocido pública y socialmente.